J'ai toujours pensé que le prompt engineering était un mot bullshit pour faire le buzz en parlant d'IA. Mais en m'y intéressant plus récemment, j'ai remarqué à quel point c'était important.

C'est logique quand on y pense : les LLM sont des machines à prédire des mots de sortie suivant le pattern des mots d'entrée. Alors si on ne donne pas le bon contexte ou qu'on explique la tâche de manière superflue, on a de grandes chances que la sortie du LLM ne soit pas alignée avec ce qu'on voulait : que ce ne soit pas la réponse parfaite !

Certes, c'est impossible de trouver une manière d'avoir la réponse parfaite à chaque fois. Cependant, le prompt engineering est une méthode permettant de s'en approcher.

Le prompt engineering, c'est le fait d'améliorer, d'optimiser ou de structurer un prompt.

Dans cet article, je vais te proposer 6 règles de prompt engineering que je tire de mon expérience, mais également d'une étude réalisée par Anthropic, le géant derrière les modèles Claude.

Même si leur technique s'applique principalement à leur modèle, ces règles sont d'après moi généralisables à tous les LLMs.

Tu peux penser l'utilisation d'un LLM comme le jeu des fléchettes : il n'y a pas de méthode miracle pour atteindre le centre, mais il y a certaines techniques, comme le prompt engineering, qui te permettent de rapprocher la sortie du LLM de celle que tu attendais.

En obtenant du premier coup le résultat désiré, tu vas gagner en performance, réduire tes coûts d'utilisation de l'IA et également réduire ton impact environnemental !

1re règle : définis toujours le rôle de ton LLM

On commence par ça, car quand tu vas rédiger ton prompt, c'est la première étape que tu dois réaliser.

Si le modèle que tu utilises le permet, tu peux placer la définition du rôle directement dans le prompt système : ça influencera d’autant plus la sortie.

En effet, le fait de définir le rôle permettra de placer le modèle dans le bon espace, c'est-à-dire d'orienter directement la sortie.

Ainsi, la tâche ne sera pas traitée de n'importe quelle manière, mais de la manière dont le modèle aura appris les méthodes de travail.

Si je souhaite traiter un volume de données qui m'est inconnu, préciser au modèle que c'est un Marketing Analyste ne le fera pas traiter la tâche de la même manière qu'un Data Engineer.

Le Marketing Analyste se concentrera peut-être plus sur les besoins, les KPI à sortir, etc. là où l'ingénieur se concentrera davantage sur l'aspect technique.

2e règle : donne du contexte sur ton projet et sois clair

Pour reprendre l'expression dans les travaux d'Anthropic :

> "Pense à un LLM comme à un employé brillant mais nouveau (ou avec une amnésie) qui a besoin d'instructions très précises."

Le modèle ne connaît pas toutes les spécificités du projet sur lequel tu travailles. Ça peut paraître logique, mais il est important de lui donner le plus de contexte possible pour orienter au mieux sa réponse.

3e règle : utilise des exemples (Few-shots)

Pour se rapprocher au mieux de ce dont tu as besoin, la meilleure manière est de montrer au LLM des exemples de réponses qui pourraient te convenir.

C'est encore plus vrai quand on fait de la structured output, c'est-à-dire quand on veut forcer le format de sortie du LLM.

En lui montrant des exemples de sortie, le LLM donnera beaucoup d'importance à ces exemples. C'est pourquoi il est important qu'ils soient pertinents et variés.

4e règle : il faut que tes prompts soient concis

Malgré tout ce qui a été dit avant (fournir du contexte, donner des exemples…), tu dois faire en sorte que ton prompt soit concis.

L'objectif n'est pas d'enlever les parties importantes, mais de simplifier grandement les phrases si besoin, et d'éviter de trop se répéter.

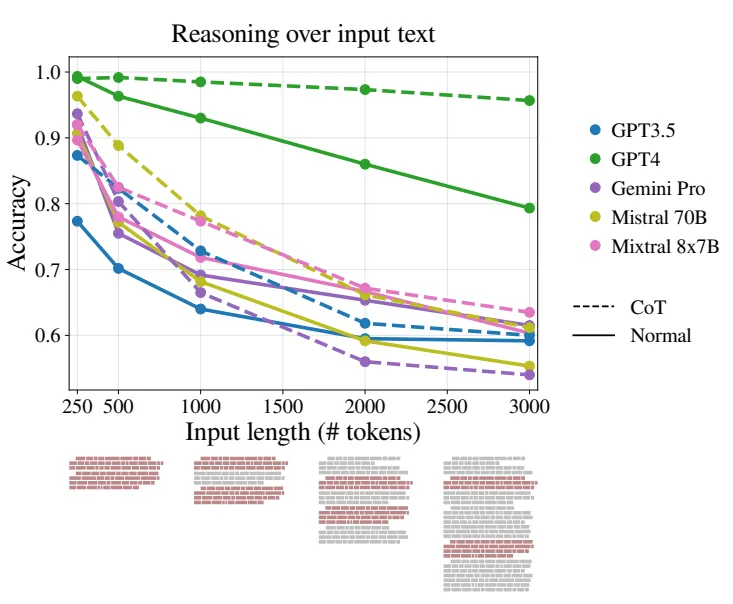

Au-dessus d'un certain nombre de tokens, les performances des LLMs chutent — à cause du phénomène 'lost in the middle'.

5e règle : structure ton prompt, soit en XML, soit en Markdown

Il faut que ton prompt soit structuré, c'est-à-dire :

- le rôle et le contexte au début,

- la tâche et les exemples à la fin.

Ça permettra au LLM de mieux comprendre le besoin.

Pour encore mieux structurer ton prompt, tu peux utiliser des formats d'écriture connus des LLM comme le XML ou le Markdown.

Je te conseille personnellement le XML, notamment si tu utilises les modèles d'Anthropic.

Utiliser XML permet de mieux structurer l'information dans le prompt.

6e règle : bonnes pratiques supplémentaires

Ces bonnes pratiques ont moins d'impact que les précédentes, mais de mon expérience, elles améliorent grandement les résultats. En voici quelques-unes à appliquer :

- •Spécifier le format de sortie

- •Pour réduire le risque d'hallucinations, on peut préciser au LLM de répondre seulement s'il connaît la réponse

- •Si c'est un modèle de raisonnement, préciser de réfléchir étape par étape, et potentiellement préciser les étapes, même si cette étape est souvent gérée côté application dans les derniers modèles qui sortent.

Conclusion + exemple de prompt

Pour conclure, voici un exemple de prompt que tu peux utiliser et qui respecte l'ensemble de ces règles.

Exemple : lancement d’une application IA.

<role>

Tu es un community manager expert en SaaS B2B, spécialisé dans le lancement de produits IA et l'engagement sur LinkedIn et Twitter/X.

</role>

<contexte>

Je lance "MeetingSummary AI", une application qui génère automatiquement des comptes-rendus de réunions Teams/Zoom grâce à l'IA. Public cible : entrepreneurs, managers et consultants qui passent 3h+ en réunion par jour.

</contexte>

<tache>

Rédige un post LinkedIn de 150-200 mots pour annoncer le lancement. Format requis :

- Hook engageant (question ou statistique)

- Présentation du problème résolu

- Bénéfice clé en une phrase

- Call-to-action avec lien

- 3-5 hashtags pertinents

Ton : professionnel mais accessible, pas de jargon technique.

</tache>

<exemples>

<exemple>

[Ajoute un exemple de post ici]

</exemple>

<exemple>

[Ajoute un exemple de post ici]

</exemple>

</exemples>

<instructions>

Réfléchis étape par étape pour créer un post qui :

1. Accroche avec une douleur concrète du public cible

2. Positionne la solution comme évidente

3. Termine par un CTA irrésistible

Réponds uniquement si tu es certain de pouvoir créer un contenu engageant.

</instructions>